Sophia Holland

Data Engineer

Aplicaciones de Inteligencia Artificial Explicativa

La inteligencia artificial explicativa —también conocida como XAI (Explainable Artificial Intelligence)— está revolucionando la forma en que usamos la IA en distintos sectores. A diferencia de los sistemas tradicionales que actúan como cajas negras, XAI permite entender cómo y por qué un modelo toma una decisión. ¿La IA rechazó un crédito? ¿Detectó una amenaza cibernética? ¿Sugirió cierto tratamiento médico? Con XAI, ahora es posible explicar esas decisiones de manera clara, confiable y útil.

En este artículo te mostraremos las principales aplicaciones de la inteligencia artificial explicativa en el mundo real. Desde la salud hasta la agricultura, pasando por la educación, las finanzas o el medio ambiente, cada sector está aprovechando esta tecnología para tomar decisiones más seguras, éticas y comprensibles.

Si estás buscando ejemplos concretos de XAI o entender cómo se usa la IA explicativa en la práctica, sigue leyendo: este es tu punto de partida para comprender cómo la transparencia en la inteligencia artificial está cambiando las reglas del juego.

Las principales aplicaciones de XAI en la actualidad son:

-

Medio Ambiente y Energía

- Clasificación de empleos en industrias verdes vs. tradicionales.

- Modelos energéticos (estabilidad de red, predicción energética).

- Evaluación de modelos climáticos.

- Análisis de factores ambientales que contribuyen a incendios forestales.

-

Educación

- Herramientas educativas con retroalimentación explicable (e.g., RiPPLE, FUMA, AcaWriter).

- Transparencia en sistemas de gestión del aprendizaje (LMS).

- Mejora del aprendizaje personalizado.

- Determinación de intereses de estudio para diseño curricular.

-

Redes Sociales

- Detección explicable de discurso de odio.

- Detección de desinformación entre plataformas sociales.

- Explicaciones con contexto social (influencia del entorno, métricas de difusión).

-

Ciberseguridad

- Detección explicable de malware.

- Detección de intrusos y anomalías en redes.

- Reglas interpretables para clasificación en ciberseguridad.

-

Finanzas

- Evaluación de riesgos crediticios.

- Detección de fraudes financieros.

- Integración con blockchain para trazabilidad.

- Modelos de préstamos entre pares (P2P) con transparencia en decisiones.

-

Derecho

- Apoyo en decisiones judiciales y análisis de contratos.

- Evaluación de evidencia generada por IA.

- Justificación de decisiones en procesos legales.

-

Agricultura

- Sistemas de recomendación de cultivos explicables.

- Análisis de condiciones agrícolas (suelo, clima).

- Soporte para agricultura de precisión y sostenibilidad.

-

Salud

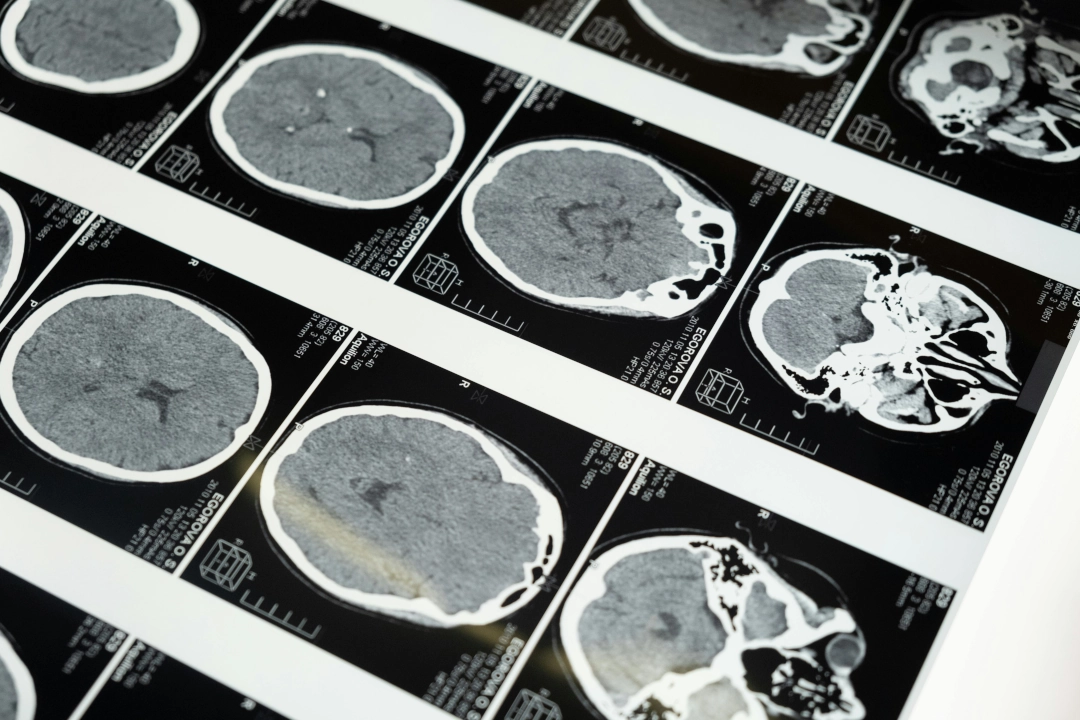

- Diagnóstico médico (con técnicas como SHAP, LIME, Grad-CAM).

- Medicina de precisión con modelos interpretables.

- Explicaciones contrafactuales en clínicas.

- Aplicaciones en medicina de emergencia (triaje, decisiones críticas).

- Mapeo de atención y saliencia en imágenes médicas.

- Colaboración segura mediante aprendizaje federado.

Medio ambiente y energía: hacia una transición más transparente

La inteligencia artificial explicable (XAI) está jugando un papel clave en la transformación verde. Por ejemplo, al clasificar ofertas de trabajo como "verdes" o "tradicionales", XAI ayuda a los responsables de políticas a entender cómo evoluciona el mercado laboral en función del cambio climático. Además, en la predicción de incendios forestales, técnicas como SHAP permiten identificar qué factores —como la temperatura del suelo o la radiación solar— incrementan el riesgo en distintas regiones. Esto convierte los modelos en herramientas estratégicas para la prevención ambiental.

Educación: explicaciones que impulsan el aprendizaje

En el aula, no basta con que un sistema diga qué debe estudiar un alumno: es fundamental saber por qué lo recomienda. XAI permite ofrecer retroalimentación comprensible a estudiantes y docentes, basándose en datos reales. Herramientas como RiPPLE y AcaWriter ya utilizan explicaciones generadas por IA para mejorar el proceso educativo. El resultado es una experiencia más personalizada, con decisiones pedagógicas respaldadas por lógica y transparencia.

Redes sociales: moderación con fundamentos

¿Te han eliminado una publicación sin saber por qué? La XAI busca resolver este tipo de situaciones, ofreciendo explicaciones claras sobre decisiones como la detección de odio o desinformación. Modelos interpretables, apoyados por herramientas como LIME, ayudan a entender qué elementos del contenido activaron una alerta. Además, al incorporar datos sociales —como el nivel de interacción o la difusión— se logra un análisis más profundo sobre por qué ciertas publicaciones se viralizan, o se consideran peligrosas.

Ciberseguridad: detectar amenazas con claridad

En el mundo digital, identificar comportamientos maliciosos es vital. Pero igual de importante es saber por qué se detectó una amenaza. Con XAI, los modelos de detección de malware e intrusiones no solo alertan, sino que explican. Herramientas como SHAP y árboles de decisión permiten a los equipos de seguridad ver qué patrones provocaron la detección, facilitando respuestas más rápidas, y minimizando falsos positivos que podrían costar tiempo y dinero.

Agricultura inteligente: cuando el campo entiende la IA

En la agricultura moderna, la IA recomienda qué sembrar, cuándo y dónde. Pero para que los agricultores confíen en estas sugerencias, necesitan saber de dónde vienen. XAI permite entender cómo variables como el tipo de suelo, el clima o la humedad influyen en cada decisión. Esto no solo mejora el rendimiento y la sostenibilidad, sino que convierte a la IA en un aliado real, útil y accesible para quienes trabajan la tierra.