James Johnson

Data Engineer

Inteligencia Artificial: Explicabilidad e Interpretabilidad en Machine Learning

1. Introducción a la IA moderna

La Inteligencia Artificial (IA) ha tomado mucha popularidad en los últimos años. El aumento de la potencia de cómputo y la capacidad de almacenar una cantidad ingente de datos ha permitido entrenar modelos de machine learning (que ya se conocían desde hace mucho tiempo) con un alto nivel de precisión y hemos obtenido una serie de resultados que nos ha permitido entender la realidad a través de los datos que generamos.

Conforme hemos ido superando mucho de estos retos en el campo de la IA, han surgido otros nuevos a los que debemos enfrentarnos. El propio nombre de inteligencia artificial deja ver que podemos llevar este debate más allá de la informática, podemos debatir en el ámbito de la filosofía. Cabe esperar entonces que muchos de estos nuevos retos tengan una componente existencial que no nos permite hacer afirmaciones tan categóricas como podemos hacerlas en otros campos.

2. El problema del razonamiento en sistemas de IA

En este post no vamos a divagar acerca de que es la inteligencia artificial, pero si vamos a abordar dos conceptos que, como antes hemos indicado, rozan el campo de la filosofía. Una vez hemos entrenado un modelo de machine learning, nos toca averiguar como predice, clasifica, genera, etc. Pero a menudo nos olvidamos de un aspecto fundamental para poder estar más seguros de que decisiones se están tomando, este aspecto del que hablamos responde a la pregunta de, ¿cómo hemos llegado a esta conclusión? Cuando realizamos una predicción a través de nuestro modelo de IA sabemos el resultado, pero no el razonamiento.

Para entender debemos abordar de manera individual el modelo de machine learning que estamos empleando. No es lo mismo usar un modelo de regressión lineal que un árbol de decisión que redes neuronales (con un mayor número de parámetros y "neuronas" o vértices).

3. Ejemplo práctico: Árbol de decisión en Machine Learning

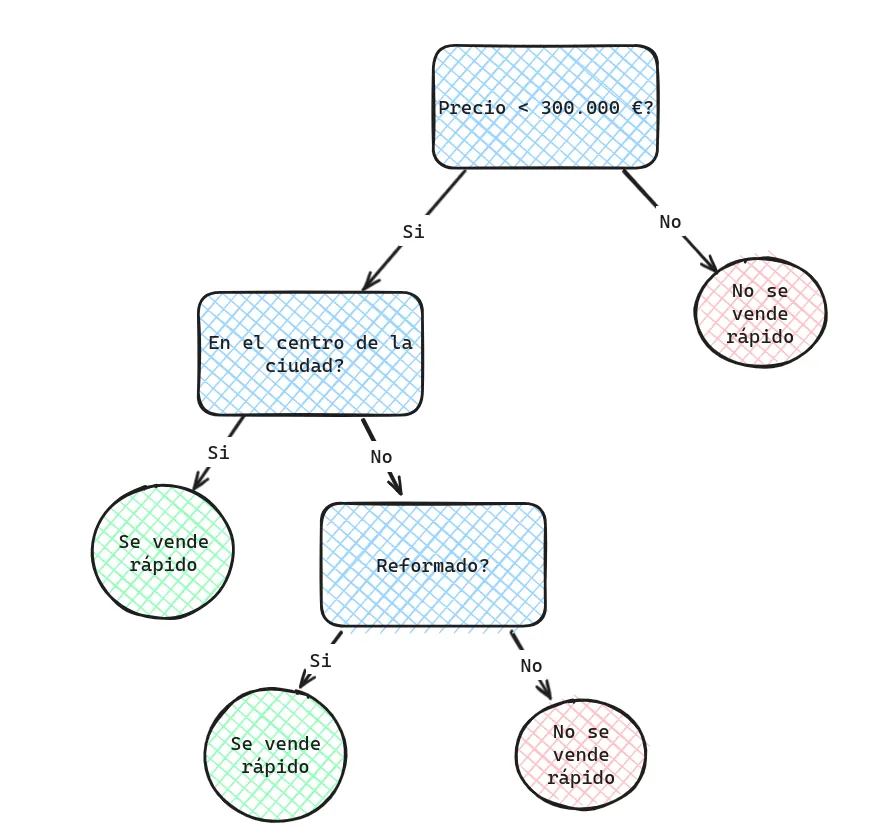

Podemos entender de una manera más o menos intuitiva como se ha llegado a una conclusión al emplear un árbol de decisión. Por ejemplo, supongamos que somos una inmobiliaria y debemos tener algún método rápido y automatizado que nos diga si un piso se podrá vender rápidamente o no para adoptar una estrategia u otra. Para ello, entrenamos un modelo de inteligencia artificial muy simple y el resultado final es el que vemos en la siguiente imagen.

Estamos de acuerdo en que si un piso que vale 450.000€ se ha predicho como que será difícil de entender por qué, sabremos de manera directa el razonamiento seguido por el modelo de IA, y es que su precio es mayor a 300.000€. Si luego tenemos un piso que vale 150.000€, no está reformado pero si en el centro de la ciudad, podremos también saber de manera inmediata por qué nuestro modelo lo ha categorizado como venta rápida, pues su precio es menor a 300.000€ y además se encuentra en el centro.

4. Interpretabilidad vs Explicabilidad en Inteligencia Artificial

A lo mejor necesitamos una base más técnica en cuanto a matemáticas para entender como funciona un modelo de regressión lineal. Sin embargo, al usar un modelo de redes neuronales con un gran número de vértices y aristas ya perdemos la trazabilidad de la decisión tomada por mucho que entendamos el modelo. Parece que hay alguna propiedad intrínseca de los modelos de machine learning que nos permitan entender el razonamiento llevado a cabo. Es en este contexto donde entra en juego los conceptos de interpretabilidad y explicabilidad en IA.

4.1 Interpretabilidad en Machine Learning

Podríamos decir que todos los modelos de IA tienen, de manera intrínseca, un cierto grado de interpretabilidad. Podemos entender esto como una propiedad interna de los mismos que muestran cuán difícil es entender el "razonamiento" seguido por el modelo para llegar a una conclusión. Como vimos en la imagen anterior, es realmente fácil saber el por qué de un árbol de decisión (a medida que se aumente el número de nodos y aristas es más difícil pero igualmente podemos determinar la trazabilidad del mismo). Nos ocurre igual con un motor de reglas proposicionales en inteligencia artificial, podemos fácilmente discernir cada "decisión" tomada pues llevar a cabo el mismo razonamiento que el modelo sin mucha dificultad.

Incluso para un modelo de regresión lineal en machine learning podemos entender fácilmente como se ha llegado a una conclusión (aunque nos cueste más entender como se han obtenido los hiperparámetros del mismo modelo). Por ejemplo, si nos dicen que la varible Y se predice de la siguiente forma: Y = aX + b, sabremos entonces que se habrá empleado dicha fórmula para predecir la variable (lo complicado aquí sería ver como obtener los hiperparámetros a y b para que optimicen nuestro modelo en base a los datos). La cosa se complica cuando trabajamos un modelo de redes neuronales con 3 capas oculpas y 7 nodos en cada capa. En dicho punto nos resulta imposible conocer la trazabilidad seguida por el modelo para saber el por qué de su decisión, en este caso, diríamos que el modelo de IA es difícil de interpretar.

4.2 Explicabilidad en IA

Es así como podemos determinar un grado de comprensión que nace de cada modelo, pero, ¿que ocurre con aquellos modelos de machine learning que son muy difíciles de interpretar? en ese caso podremos tratar de emplear herramientas externas que nos arrojen un poco de luz sobre las decisiones de nuestra inteligencia artifical. Al conjunto de resultados que estas herramientas nos otorgan las podemos catalogar como explicabilidad en IA. Es decir, la explicabilidad de un modelo la conseguimos a través de técnicas externas a los mismos que nos indican como han "razonado" estos para tomar una decisión. En el caso mencionado previamente, podríamos emplear el vector de Shapley (muy recurrido en la teoría de juegos, que tuvo un gran impulso debido a la intervención de Von Neumann) para que nos pondere y correlacione las distintas variables que entran en juego dentro de nuestro modelo de machine learning.

5. Conclusión sobre Explicabilidad e Interpretabilidad en IA

Como conclusión, podríamos decir que todo modelo de inteligencia artificial tiene un cierto grado de interpretabilidad y a todo modelo podemos aplicarle técnicas que nos ofrezcan explicabilidad sobre el mismo, ya es criterio nuestro determinar cuando usar un método o tratar de razonar el otro. Tal vez no tenga sentido aplicar un modelo LIME para ofrecer explicabilidad sobre el algoritmo de los K-vecinos más cercanos, pues de manera casi intuitiva podemos determinar como se ha predicho un valor de este modelo de machine learning. La explicabilidad en IA se vuelve crucial cuando implementamos sistemas de inteligencia artificial en entornos donde las decisiones tienen un impacto significativo en la vida de las personas.